-

[모두를 위한 딥러닝] 2. Linear RegressionAI/모두를 위한 딥러닝 2020. 11. 19. 01:37

# Linear Regression

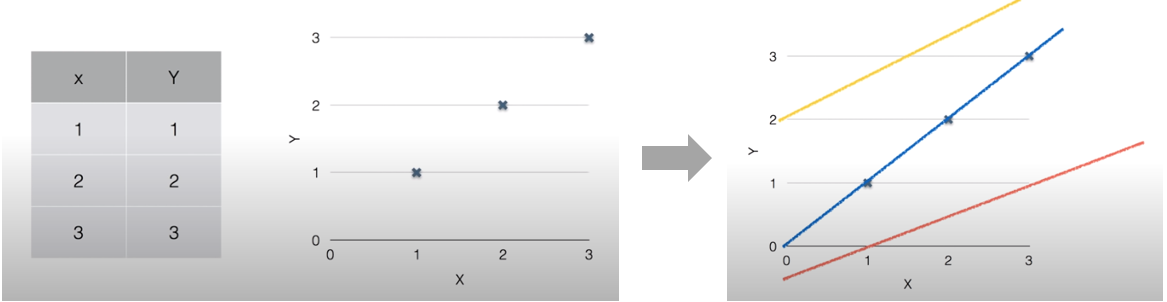

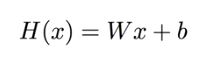

주어진 학습 데이터를 가장 잘 설명할 수 있는 선을 찾아 분석하는 방법이다. (Regression은 연속하는 값을 가지는 학습 데이터에 한해 사용한다.) 위 그림처럼 주어진 데이터를 그래프에 표현하고 여러가지 선을 긋다보면 파란선이 해당 데이터를 가장 잘 표현함을 알 수 있다. 이러한 선을 H(x) = Wx + b의 형태의 수식으로 찾아내는 것을 Linear Regression이라고 한다. 위 그림의 파란선은 H(x) = x로 나타낼 수 있다.

# Loss & Cost function

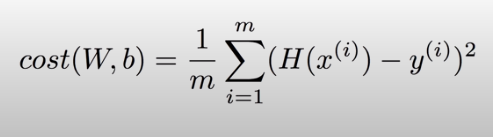

Cost function은 예상한 가설(선)이 데이터에 얼마나 잘 맞는지 확인하는 함수이다. 보통 예측값에서 실제값을 뺀 값의 제곱인 (H(x) - y)²을 Loss로 사용하여 Cost function을 구한다.

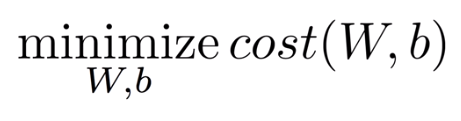

즉 이렇게 계산한 모든 Loss의 평균을 내면 Cost function을 구할 수 있다. 딥러닝에서는 주로 이 Cost function이 사용되고 이러한 Cost function을 최소화시키는 W, b를 찾는 것이 목표가 된다.

본 포스팅은 김성훈 교수님의 강의

'모두를 위한 딥러닝'을 학습하고 정리한 내용을 담고 있습니다.

'AI > 모두를 위한 딥러닝' 카테고리의 다른 글

[모두를 위한 딥러닝] 7. Learning rate, Overfitting and Regularization (0) 2020.12.01 [모두를 위한 딥러닝] 6. Multi-Class Classification - Softmax (0) 2020.12.01 [모두를 위한 딥러닝] 5. Logistic Regression (0) 2020.11.25 [모두를 위한 딥러닝] 4. multi-variable linear regression (0) 2020.11.25 [모두를 위한 딥러닝] 1. Machine Learning 개요 (0) 2020.11.18